08

07/2016

奇异值分解及其应用(转)

原作者:http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html前言: 上一次写了关于PCA与LDA的文章,PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。在上篇文章中便是基于特征值分解的一种解释。特征值和奇异值在大部分人的印象中...

02

06/2016

R vs Python(转)

转自:https://www.datacamp.com/community/tutorials/r-or-python-for-data-analysis

10

05/2016

标注偏置问题(Label Bias Problem)(转)

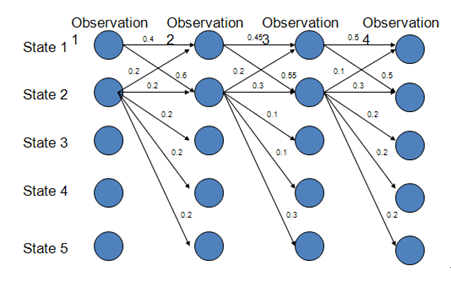

路径1-1-1-1的概率:0.4*0.45*0.5=0.09路径2-2-2-2的概率:0.018路径1-2-1-2:0.06路径1-1-2-2:0.066由此可得最优路径为1-1-1-1而实际上,在上图中,状态1偏向于转移到状态2,而状态2总倾向于停留在状态2,这就是所谓的标注偏置问题,由于分支数不同,概率的分布不均衡,导致状态的转移存在不公平的情况。PS:标注偏置问题存在于最大熵马尔...

10

05/2016

判别式模型和产生式模型(转)

判别式模型( discriminative

model )产生式模型( generative

model ) 特点寻找不同类别之间的最优分类面,反映的是异类数据之间的差异对后验概率建模,从统计的角度表示数据的分布情况,能够反映同类数据本身的相似度区别 ( 假定输入 x,类别标签 y)估计的是条...